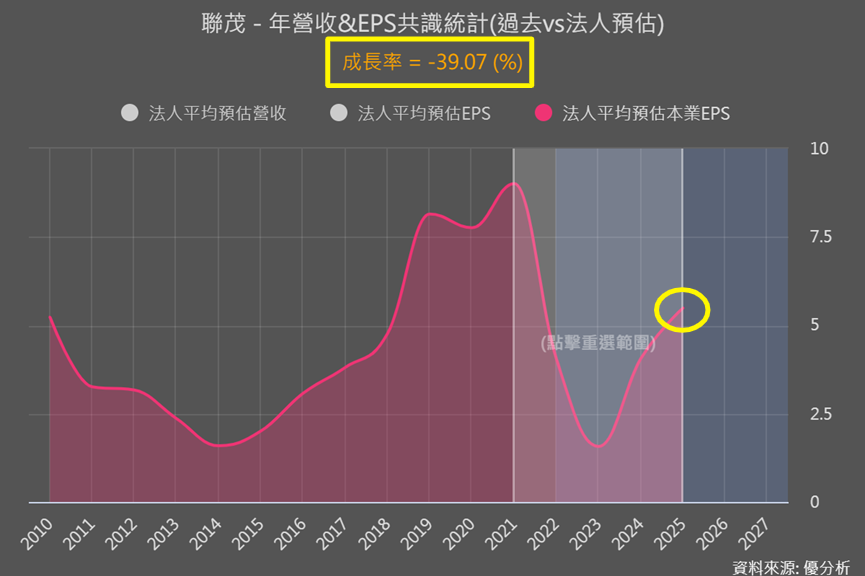

9月13日(優分析產業訊息中心) - 8月的時候銅箔基板(CCL)供應商聯茂(6213-TW),被法人預估到了2025年不但無法和同業台光電(2383-TW)與台燿(6274-TW)一樣,超越或接近過往營運高點,甚至還差了近40%!(之前文章見此連結)

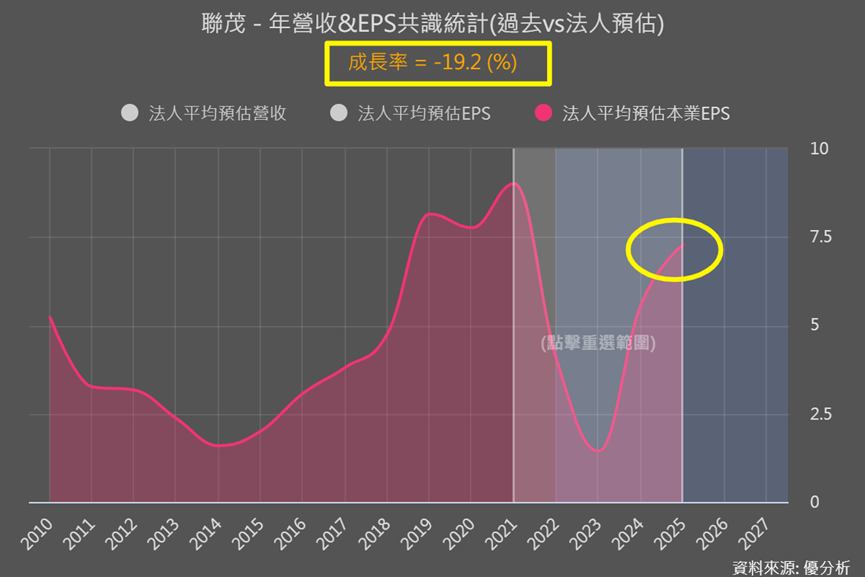

但到了9月,聯茂204-2025年的本業EPS預估值明顯上調,雖然仍和過往高點有明顯落差,但相差的幅度已從近40%縮小到近20%。

法人調高預估值的理由是什麼?

先複習台光電為何明顯受惠AI

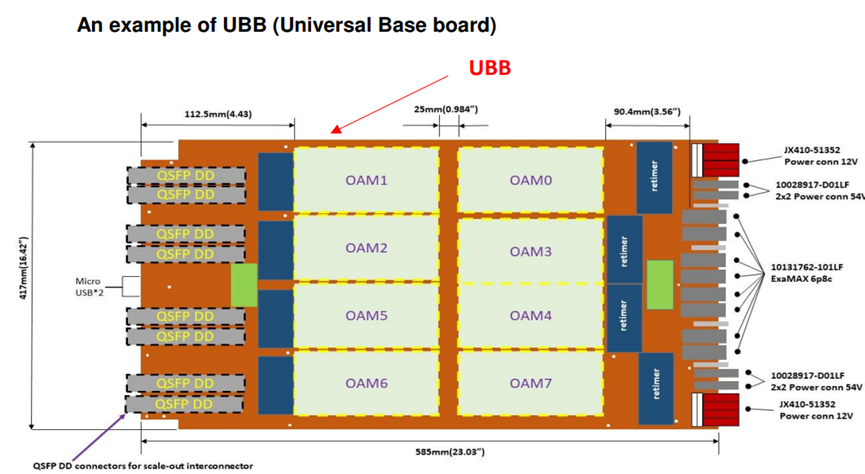

在公認的GPU平台硬體設計標準中,UBB(通用基板)和OAM(加速器模組)是不可或缺的。OAM模組用來承載GPU,UBB則是用來承載OAM。下圖可以看到8個配有GPU的OAM模組,放在一塊通用UBB板上(咖啡色部分),讓8個GPU之間互相連接發揮作用。

AI伺服器UBB、OAM使用的CCL用量和價值齊增,整體AI伺服器使用的CCL,被預估價值可能是一般伺服器的6-8倍,而最新的法人報告則提高到8-10倍!

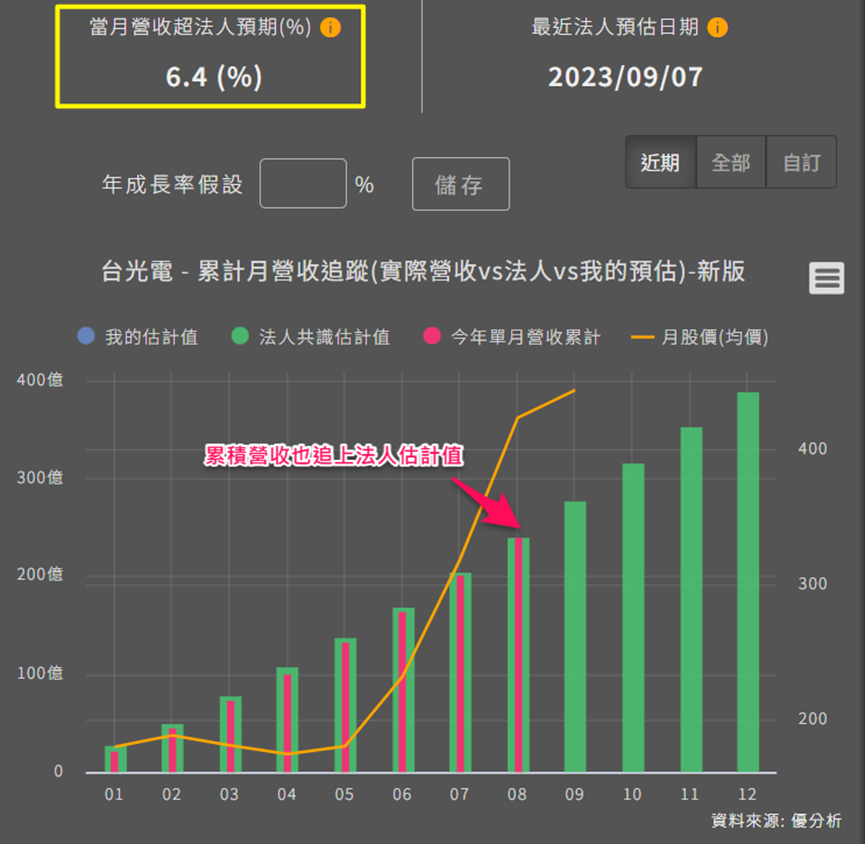

而台光電(2383-TW)在AI伺服器UBB、OAM中都有很高的市占率,尤其OAM目前被認為擁有獨家供應的地位。最新8月營收表現超出法人預期6.4%。

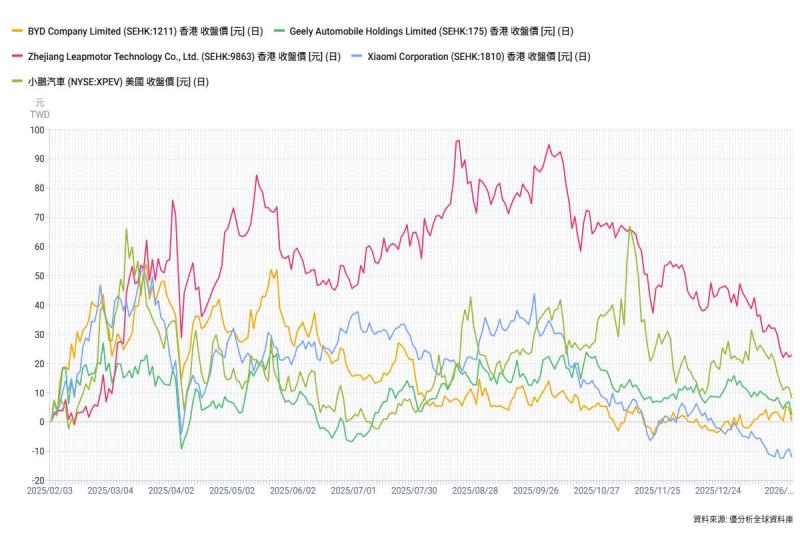

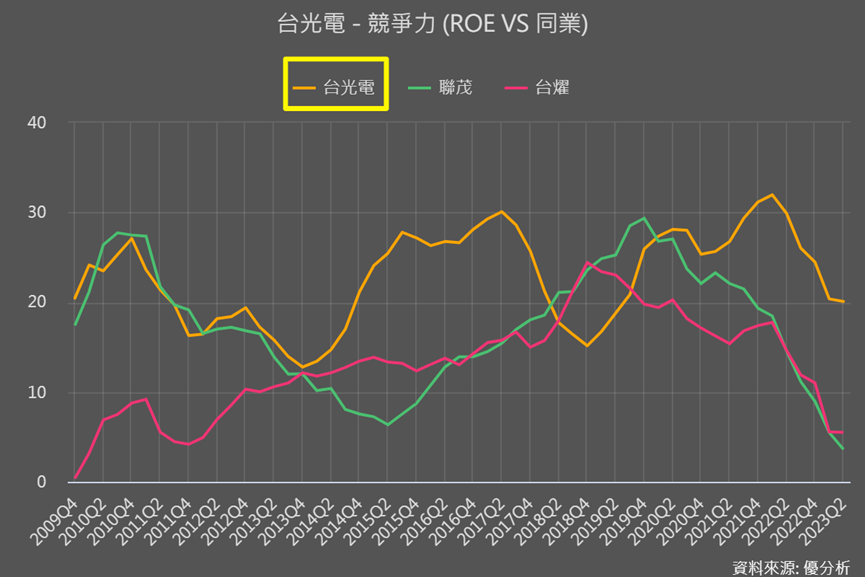

下圖也能看到,台光電的整體經營績效2022年以來,和其他兩家同業完全不同。

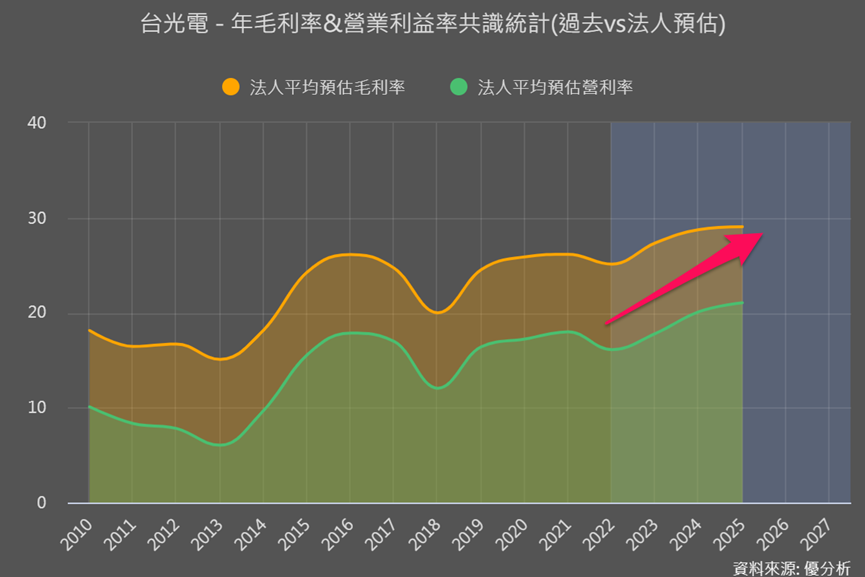

法人認為從中長期來看,台光電在AI伺服器CCL市場領先地位,會持續推動強勁的營收和毛利率增長。

但隨著輝達AI GPU變動,同業也出現變化。

輝達(NVDA-US) AI GPU種類變化

●A100:採用台積電的7奈米製程、目前單位售價約為1.2-1.5萬美元。

●H100:目前輝達訓練速度更快、性能最強大的GPU,採用5奈米家族製程(接近4奈米),目前單位售價約為3萬美元,但每美元產生的效能比A100高出約4-5倍,可以說是CP值超高!

以上兩種目前的主流AI GPU,都採用產能緊繃的 CoWoS與很難跟上AI晶片快速成長節奏的高頻寬記憶體(HBM)。

為解決AI晶片缺貨問題,輝達2023/8緊急宣布要推出不搭載高頻寬記憶體(HBM)、不使用 CoWoS封裝的新款GPU「L40S」。

●L40S:2023Q3推出,單位售價約1萬美元。雖傳輸速率和效能都比上述兩種晶片差,但被看好在AI推論和小規模演算訓練上,能略優於 A100。也因為產能不缺又比較便宜,被看好能取代A100、填補AI市場中較低階的缺。

●GH200:2023年輝達發表的新款AI晶片,預計2024Q2出貨。這款新晶片比是專門為類似OpenAI的ChatGPT等大型語言模型公司所設計,比起H100,有效節省成本、功耗,可以發揮到更大的效能,且可容納更多內存記憶體,尚未透露定價,但目前法人預估上看4萬美元。

要注意貢獻程度

而被看好能取代A100的L40S,相關CCL供應鏈就是聯茂(6213-TW)和台燿(6274-TW),所以近期出現了補漲的情況。

|

|

材料等級 |

玻纖種類 |

層數 |

CCL供應商 |

|

UBB(通用基板) |

M7 |

NE Glass |

20-30 |

台光電、台燿、聯茂、Panasonic、Doosan(韓國廠) |

|

OAM(加速器模組) (H100/A100) |

M7+HDI |

NE Glass |

24-28 |

台光電 |

|

L40S卡 |

M6 |

E Glass |

10 |

台燿、聯茂、南亞(1303-TW) |

法人也因此針對AI的變動、重新評估了CCL產業,調高的原本不看好的聯茂2025年EPS預估值。

可是從上表我們也能看到,L40S這個作為驅動額外AI需求的A100替代品,所使用的CCL,不但兩種材料等級都沒那麼高,且層數明顯低很多。

就可以知道其實L40S含金量不高, 對CCL供應鏈貢獻也有限。而我們也可延伸,誰能成為接下來價格被預估上看4萬美元的GH200 晶片供應鏈才是重點。

|

法人預估價格趨勢 |

L40S |

A100 |

H100 |

GH200 |

|

單元價格(美元) |

約8千 |

約1萬 |

約2.3萬 |

上看4萬 |