生成式 AI 解決方案(aiDAPTIV+),是一種整合硬體和軟體的AI模型微調訓練解決方案,進一步優化AI訓練模型的數據存取效率。

當應用的大幅擴大,人們對於儲存資料的需求及傳輸速度要求也大幅增加,OpenAl近期出的Sora,只要給它簡單的幾行文字即可生成流暢的A影片,未來需求只會更大。

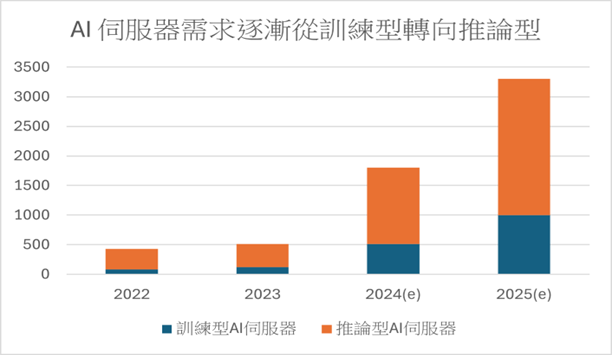

隨著大型語言模型的訓練需求增加,雲端的通用模型開發業者(OpenAI、META)採購訓練型 AI 伺服器,開發成通用模型軟體(Sora、ChatGPT),個別企業再採購通用模型+租用訓練型 AI 伺服器+現有資料進行場域訓練,開發為【專用模型】。

(資料來源:優分析整理)

大型語言模型 (LLM),就是一個讓電腦能理解、使用人類語言的工具。建立在深度學習 (機器學習的子領域) 的基礎之上,LLM 經過預先訓練,並仰賴上千萬個參數並行處理的巨量資料所組成的神經網路。

隨著通用模型逐步開發完成,大型語言模型的訓練主要由雲端的訓練型 AI 伺服器進行,而推論主要由邊緣端的推論型 AI 伺服器完成。

2024~2025年,設備的採購需求來自於模型開發業者或雲端服務業者。至2025年後,隨通用模型逐步開發完成並推廣後,設備的採購需求轉向企業,甚至是個人。

(資料來源:TrendForce)

根據 UC Berkely 的研究,當前訓練型的AI伺服器使用的NAND Flash需求量約在十億GB左右;大型語言模型參數數量每兩年以 410 倍的 速度成長,而 DRAM 的運算頻寬僅以每兩年 2 倍的速度成長,此類記憶體晶片效能落後邏輯晶片運算能力。

2023年起,HBM生產良率較低,供給緊缺,造成HBM的報價大幅高於DRAM及NAND Flash,墊高AI伺服器的採購成本。群聯推出aiDAPTIV+方案,將 SSD 作為 DRAM 使用,即時支援 GPU 運算的資料暫存需求,以擴充 AI 伺服器整體記憶體容量。以現況 AI 伺服器方案的系統建置成本達 200 萬美元; 而 aiDAPTIV+方案的系統建置成本僅 2-3 萬美元。

研華(2395-TW)的AI邊緣運算解決方案與群聯(8299-TW)「aiDAPTIV+」合作,既加強AI LLM的能力,且提供了全面的AI部署軟硬體整合。讓中小企業不再因高昂的硬體配置,即可執行AI LLM 運算;並利用Edge AI軟體解決方案,更加擴展此生態系統,包括預訓練模型、開發平台、工具和服務等,有效地促進了AI應用的可及性。

這次雙方攜手,開發「平民化」GenAI落地方案,加速智慧工廠、智慧醫療、智慧物流等智慧應用的普及。