Nvidia(NVDA-US)最近發布的一個更新的消息:他們為AI晶片加入了新功能。這一升級將會使 Nvidia 的晶片在處理大型 AI 系統方面更加出色。

H200 晶片的亮點

Nvidia 宣布其新的旗艦晶片 H200,預計明年開始在亞馬遜(Amazon.com)、谷歌(Alphabet's Google)和甲骨文(Oracle)等公司推出。這款晶片將會超越目前的頂級 H100 晶片。

H200 最主要的升級是增加了更多的高頻寬記憶體,這是晶片中最昂貴的部分之一,也決定了晶片能多快處理數據。

高頻寬記憶體和快速連接

H200 擁有 141 GB 的高頻寬記憶體(HBM),相較於以前的 H100 的 80 GB 有顯著提升。這意味著,像 OpenAI 的 ChatGPT 這樣的服務,以及許多其他基於生成性 AI 的服務,將能夠更快地產生回答。

目前Nvidia並沒有公布記憶體的供應商,不過根據美光(Micron)九月時的說法,他們正在與Nvidia合作開發產品。

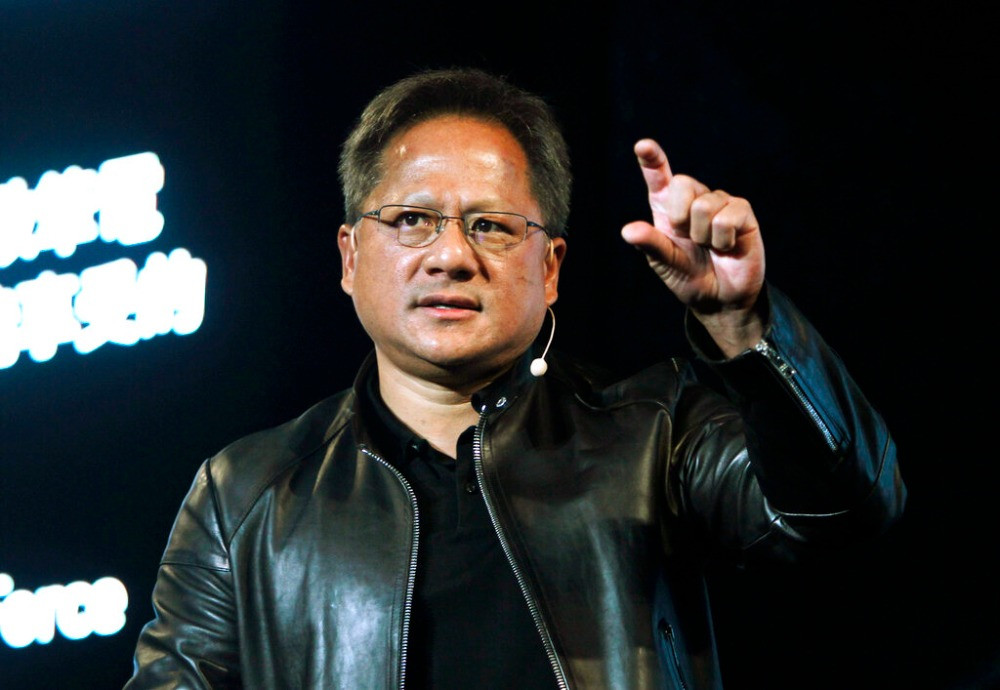

Nvidia 在 AI 晶片市場的地位

Nvidia 在 AI 晶片市場佔據主導地位。他們不僅僅是供應 ChatGPT 服務的動力來源,還支持許多其他具有類似人類寫作回應能力的生成性 AI 服務。

雲服務提供者的支持

值得一提的是,亞馬遜網絡服務(AWS)、谷歌雲、微軟 Azure 和甲骨文雲基礎設施將是首批提供 H200 晶片訪問的雲服務提供商。此外,專注於 AI 的雲服務提供商 CoreWeave、Lambda 和 Vultr 也將支持這一晶片。