2025年11月13日(優分析/產業數據中心報導)⸺ 百度(Baidu)此次發布新AI晶片與超級運算產品,關鍵意義在於「強化中國本土AI算力供應鏈」、降低受制於美國晶片出口管制的風險。隨著美中科技緊張升高、特別是美國對高階AI晶片的限制持續收緊,百度透過自研運算硬體建構更完整的AI基礎設施,等同為未來AI商業化奠定更具自主性的底層能量。

在產品路線上,百度公布兩款新晶片:主攻推論場景的 M100 預計於2026年初上市,而可同時支援訓練與推論的 M300 預計在2027年初推出。兩者定位清晰,顯示百度正逐步從推論晶片跨向更高門檻的訓練晶片領域,意在與全球AI硬體競爭保持節奏。

此外,百度同步發布兩款「超節點(supernode)」系統,以高速網路串聯多顆晶片,以突破單晶片效能瓶頸。其中「天池256」(Tianchi 256)將由256顆P800晶片組成,預計2026年上半年上市;而強化版則以512顆P800晶片構成,計畫於2026年下半年推出。這類產品的戰略目標十分明確:以大規模算力支撐AI模型訓練需求,並與華為已推出的含384顆昇騰910C晶片的 CloudMatrix 384 系統形成正面競爭。

最後,百度也更新其大型語言模型「文心」(Ernie),強調在文字、圖像與影片分析上的能力提升,代表百度正同時強化晶片、算力平台與模型產品的完整閉環,有助提升AI商業落地速度與市場競爭力。

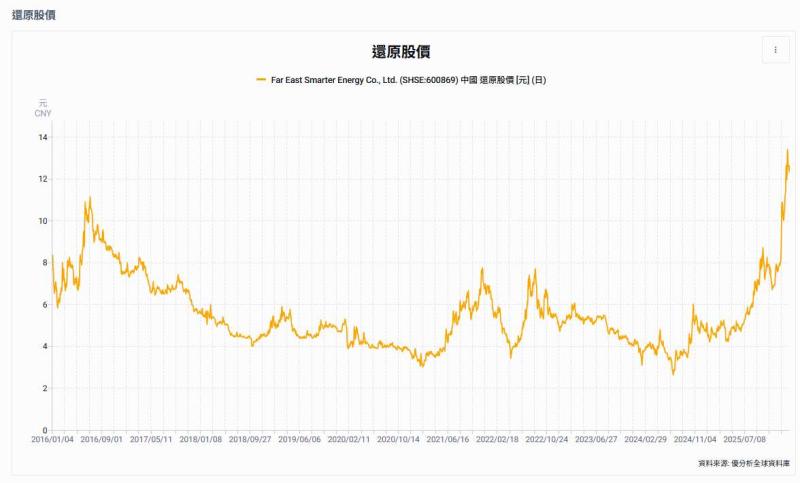

中國廠商自研晶片取代輝達晶片

除了百度以外,阿里巴巴也自2025年開始已使用自研晶片來訓練部分較小型的AI模型,並逐步替代Nvidia晶片。雖然阿里與百度仍依賴Nvidia進行最先進模型的訓練,但阿里巴巴的新AI晶片效能已足以與Nvidia在中國可銷售的 H20 晶片競爭。

從產業格局來看,百度推出M100與M300晶片與天池超節點系列,加上阿里巴巴加速採用自家晶片,代表中國AI雲端巨頭正從商業應用端一路向下整合至算力基建層。這不僅會削弱Nvidia在中國市場的依賴度,也代表中國AI生態系在2025–2026年間進入一個「自主晶片與自研大模型並進」的新階段。